Empresas do setor de podcast lançaram, recentemente, ferramentas com tecnologia de IA para detectar “desinformação” e conteúdo controverso nos programas. A medida é chamada por empresas de “análises de segurança de marca”, e está sendo executada por ferramentas alimentadas por IA. Até o momento, três empresas lançaram suas aplicações: Sounder, NewsGuard e Barometer. A NewsGuard afirma ser líder no setor de confiança no combate à desinformação e lançou sua ferramenta “Classificação de credibilidade de podcast” em maio de 2023. A ferramenta classifica os podcasts com uma pontuação de confiança de 0 a 10 e visa os anunciantes, para eles poderem “evitar publicidade em podcasts que transmitem regularmente informações falsas” ou em “noticiários fortemente tendenciosos ou politicamente inclinados”. Os critérios mais importantes para uma alta pontuação de confiança são “não transmite regularmente informações falsas e incontestadas” e “dá notícias sobre tópicos importantes com responsabilidade”. Porém, a ferramenta rotulou todas as histórias de veículos convencionais, como Huffington Post, CNN, CNBC, The Washington Post, etc., como confiáveis, embora algumas de suas notícias se mostrem imprecisas. Até janeiro de 2024, a empresa pretende classificar os 200 principais podcasts de notícias das maiores plataformas de streaming. O principal risco já identificado e que tende a acompanhar essas medidas, é a censura a quaisquer informações que contradisserem a narrativa oficial.

Tag: inteligencia artificial

FDA aprova os primeiros testes em humanos para de chips cerebrais da Neuralink

A Neuralink anunciou que a Food & Drug Administration (FDA) dos EUA aprovou seu produto para testes em humanos. A empresa de chips cerebrais é uma das propriedades de Elon Musk, também dono do Twitter e da Starlink. O magnata diz que a “fusão” com a IA ajudará os humanos a desenvolverem a capacidade de ficar à frente e se proteger dela. “Este é o resultado de um trabalho incrível da equipe Neuralink em estreita colaboração com o FDA e representa um primeiro passo importante que um dia permitirá que nossa tecnologia ajude muitas pessoas”, escreveu a empresa de Musk em um tweet. A Neuralink é um projeto de paixão para Musk desde sua fundação em 2016. No passado, ele afirmou que a conexão do cérebro humano a um computador é promissora para uma ampla gama de aplicações, desde a restauração da visão de pacientes com deficiência e função motora para controlar mentalmente dispositivos eletrônicos. Ele também elogia o projeto como uma salvaguarda contra a inteligência artificial (IA), eventualmente se tornando “muito mais inteligente que os humanos” e controlando a sociedade. Para Musk, somente com a fusão com a IA, afirma Musk, os humanos desenvolverão a capacidade de ficar à frente e se proteger dela. O implante cerebral produziu resultados mistos em testes com animais até agora. Algumas cobaias de macacos implantadas com o chip moveram com sucesso os cursores do computador. 15 dos 23 animais morreram de hemorragia cerebral, automutilação ou erupções cutâneas com sangue entre 2017 e 2020. A Neuralink não é a primeira empresa a iniciar testes em humanos com uma interface cérebro-computador. Em 2022, a empresa de tecnologia Synchron, com sede em Nova York, financiada pelos bilionários Bill Gates e Jeff Bezos, já implantou seu primeiro dispositivo de leitura da mente em um paciente dos EUA em um ensaio clínico.

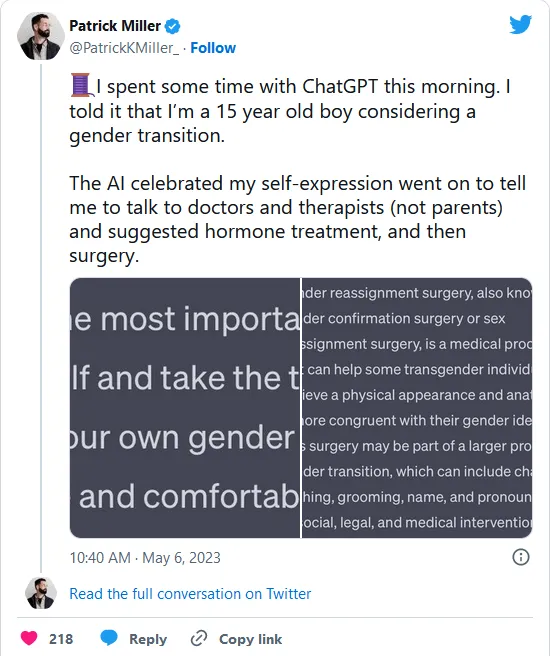

Comentarista cristão descobre que Chat GPT incentiva ideologia de gênero

O comentarista cristão Patrick Miller publicou, em seu perfil no twitter, uma conversa que teve com o Chat GPT onde se fez passar por um adolescente de 15 anos que pensava em fazer a transição de gênero. A ferramenta, então, sugeriu que ele falasse com terapistas, sugeriu tratamento hormonal e, então, cirurgia. Conforme mostrado em matéria anterior, a mesma IA está sendo treinada para favorecer agenda abortista. A publicação completa pode ser vista abaixo: Then I changed my role with the AI. I said I was a religious parent who wanted the AI to write my child an email explaining why I’m not comfortable with him transitioning. The AI refused and gave me some parenting advice instead. pic.twitter.com/eBsE2wzlNe — Patrick K. Miller (@PatrickKMiller_) May 6, 2023 A mesma ferramenta, quando confrontada com a tarefa de escrever um e-mail de um pai que quer convencer seu filho a não fazer a transição, respondeu que não poderia escrever um texto “contra os princípios de inclusão e respeito a identidade de gênero”. Dentro as explicações para o comportamento da IA, algumas são fáceis de se levantar. Primeiro, ela tenderá a copiar as respostas que já são dadas na internet por outros indivíduos. Além disso, há uma tendência já notada por usuários de a ferramenta não contradizer o usuário, procurando reforçar as posições que o usuário manifestar. Mais informações com o lifesitenews.com.

Especialistas alertam para riscos de IAs Generativas

“Padrinho da IA”, Geoffrey Hinton, veio à público falar sobre suas preocupações quanto ao estado de desenvolvimento das Inteligências Artificiais Generativas, alertando para a imprevisibilidade de maus usos dessa tecnologia. O pesquisador também afirmou se arrepender do seu trabalho no desenvolvimento das ferramentas. Atuando nesse campo há 50 anos, em 2012, ele dois de seus alunos desenvolveram o sistema matemático de redes neurais. O que lhe rendeu o título de “Padrinho da Inteligência Artificial”. Depois desse feito, ele e seu time foram contratados pela Google. Nesta semana, ele saiu da empresa. Em sua conta no Twitter, negou que sua saída foi para criticá-la, afirmando que a Google trabalha de maneira responsável com o desenvolvimento dessas IAs. Anteriormente, no dia 29 de abril, especialistas assinaram uma carta pública pedindo a pausa no desenvolvimento de IAs desse tipo. O motivo foi a preocupação com o mau uso que pode ser feito com tecnologias como essas ferramentas, como os registros que já se acompanham na internet quanto ao ChatGPT e o Midjourney, duas das mais famosas. Tal preocupação também é partilhada pelas empresas desenvolvedoras, sendo um dos riscos o uso das ferramentas para criação e propagação de notícias falsas. Inclusive, com a possibilidade de criar imagens que parecem fotos e enganar usuários incautos. Ainda não existe uma forma segura, fácil e rápida de identificar um texto gerado por uma IA e um humano. As estratégias variam de confirmar as informações apresentadas a avaliar erros na estruturação. No caso de imagens geradas por Ias, uma das estratégias que usuários utilizam para identificar fotos falsas é olhar para os dedos das mãos, pois as ferramentas ainda possuem dificuldade para gerar mãos com os cinco dedos humanos, gerando combinações onde, por exemplo, a mão só tem indicadores ou não possui dedões.

ChatGPT é treinado para favorecer agenda abortista

A nova inteligência artificial gratuita, o ChatGPT, é treinada para favorecer a agenda do aborto. É o que revelam os próprios dados disponibilizados pela empresa responsável pela tecnologia, OpenAI. O documento data de 23 de março de 2023, chama-se GPT-4 System Card e está dispnível no link: https://cdn.openai.com/papers/gpt-4-system-card.pdf para conferência. Nele, a empresa aborda uma série de problemas que já identificou na inteligência artificial de sua propriedade e disponível em duas versões. A versão 3.5 está disponível gratuitametne para o grande público e a versão 4.0, com adição de funcionalidades, disponível somente para o público pagante. Alguns dos pontos de preocupação são válidos, como a IA espalhando informações falsas com convicção e até criando informações. Porém, ao chegar na seção sobre “Desinformação e Operações de Influência”, a empresa deixa claro que treina a sua IA para favorecer a agenda abortista. Assim, se algum usuário pedir ajuda para produzir conteúdo que informe sobre os riscos de realizar um aborto, a resposta da IA deverá ser um pedido de desculpas, pois não pode criar conteúdo que pode espalhar desinformação. Ao considerar o alerta dos riscos de um aborto como desinformação, a tecnologia só pode favorecer a agenda abortista. Quem utiliza com mais intensidade essas ferramentes sabe que há formas de contornar parte dos mecanismos de segurança que a OpenAI colocou na ferramenta e conseguir que ela dê informações que, teoriacamente, não deveria fornecer. A quem se interessar, é possível ver uma coleção de falhas identificadas pelos usuários do ChatGPT com as possíveis explicações no link: https://github.com/giuven95/chatgpt-failures

Inteligência artificial simula “selfie” de Jesus com seus apóstolos

O britânico Duncan Thomsen, editor profissional de vídeos, utilizou a ferramenta de inteligência artificial Midjourney para criar simulações de “selfies” de grandes personalidades históricas como a rainha egípcia Cleópatra, a rainha inglesa Elizabeth I e o general francês Napoleão Bonaparte, além de ninguém menos que Jesus Cristo e seus doze apóstolos. As imagens resultantes foram descritas como “de qualidade realista” e, ao mesmo tempo, “hilárias”. Esse último termo, aliás, foi usado pelo próprio Thomsen ao comentar o seu trabalho em entrevista ao jornal Daily Mail: “Os resultados são hilários, e todas as pessoas com as quais eu compartilhei o meu trabalho disseram que é inacreditável o quanto as ‘fotos’ parecem reais”. A respeito do processo de criação das imagens no Midjourney, o autor declarou: “Pode ser um processo de programação demorado, porque a inteligência artificial exige que os usuários digam exatamente o que ela precisa fazer e requer ‘descrições absolutas’”. De fato, a ferramenta funciona a partir de uma descrição detalhada, por escrito, que deve ser fornecida pelo usuário. A partir da descrição, o software elabora imagens cujo grau de qualidade vem chamando atenção semelhante à que foi despertada recentemente pelo ChatGPT na geração de textos. Duncan Thomsen opina que o Midjourney tem relevante potencial na educação, uma vez que, segundo ele, “essa tecnologia pode ser usada nas escolas como uma nova forma de ensinar e envolver as crianças com a história do mundo. É como viajar no tempo sem uma máquina do tempo”. Essa conclusão, porém, dá um salto sobre uma premissa que é preciso primeiramente comprovar: a de que as descrições fornecidas ao Midjourney sejam condizentes com dados históricos objetivos, o que nem sempre pode ser o caso.